根据大脑信号重建其他人眼中的世界,这种“读心术”听起来像是科幻中才有的场景。的确,我们尚且不需要担心自己脑海中的画面被他人读取,但不少科学家正利用AI取得阶段性的进展。例如就在两天前,一项

《自然》子刊研究

展示了一种可以将大脑活动转换为持续语言输出的脑机接口,其通过分析功能磁共振成像数据就能将参与者大脑中的故事甚至图像用语言描述出来。

今天,一项发表于《自然》杂志的研究朝着“AI读心”的目标取得了又一项重要进展。来自洛桑联邦理工学院(EPFL)的研究团队构建了一种全新的人工神经网络模型,能够准确捕捉大脑活动的动态变化。在实验中,该模型从小鼠的大脑信号中几乎完美地提取了黑白电影的画面。研究团队将这款全新的机器学习算法命名为CEBRA。

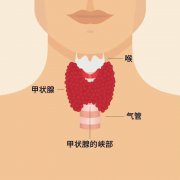

当然,需要说明的是,这套AI工具并不是直接“从无到有”地重现小鼠脑中的画面,而是将小鼠看见的电影片段与实现训练的电影帧对应起来。具体来说,研究团队让50只小鼠观看一段长30秒的黑白电影剪辑片段,这些小鼠看了9次,每一次研究团队都会借助插入小鼠大脑视觉皮层区域的电极探针或是光学探针(即通过基因改造,使得被激活的神经元发出绿色光),收集小鼠的神经元活动信号。随后,研究团队训练CEBRA将神经信号与600帧的电影片段联系起来,建立起两者的映射。

▲研究团队根据小鼠的大脑活动,预测它们看见的电影片段(图片来源:EPFL/Hillary Sancutary/Alain Herzog/Allen Institute/Roddy Grieves)

在学习了小鼠视觉系统神经编码中的隐藏结构后,CEBRA可以在初始的训练阶段之后,直接从大脑信号中预测看不见的电影帧。

于是,在这些小鼠第10次观看电影剪辑片段时,CEBRA根据大脑活动信号来预测小鼠看见的画面。重建的结果如下方视频所示:CEBRA成功预测出小鼠正在看的是一位男子跑向一辆汽车、打开后备箱,然后溜走的画面。尽管有少量失真的地方,但重建的电影片段几乎和原始片段一致。在95%的情况下,CEBRA预测的帧的位置,都与小鼠实际看见的差距在1秒之内。