Pine 萧箫 金磊 发自 凹非寺

量子位 | 公众号 QbitAI

“AI确实可能杀死人类。”

这话并非危言耸听,而是OpenAI CEO奥特曼的最新观点。

而这番观点,是奥特曼在与MIT研究科学家Lex Fridman长达2小时的对话中透露。

不仅如此,奥特曼谈及了近期围绕ChatGPT产生的诸多问题,坦承就连OpenAI团队,也根本没搞懂它是如何“进化”的:

从ChatGPT开始,AI出现了推理能力。但没人能解读这种能力出现的原因。

唯一的途径是向ChatGPT提问,从它的回答中摸索它的思路。

针对马斯克在推特上的“危险论”,他直言:

马斯克在我心中是英雄,我支持也理解他的担忧。

虽然他在推特上挺混蛋的,但希望马斯克能看到我们在解决AGI安全问题上付出了多大的努力。

除此之外,在这场对话过程中,奥特曼还提到了不少刁钻的话题,例如:

-

ChatGPT、GPT-4开发的内幕

-

GPT-4是人类迄今所实现的最复杂的软件

-

如何看待大家拿ChatGPT越狱

-

……

在看过这场对话之后,网友直呼:

两位AI大佬用大家都能理解的方式聊AI,多来点这样的访谈。

那么接下来,我们就来一同看下他们这场深度对话。

GPT-4内幕大曝光

GPT-4是这场对话中最受关注的部分。

它是如何训练的?如何在训练模型时避免浪费算力?如何解决AI回答不同价值观的人的问题?

首先是训练过程,依旧是预训练+RLHF,不过透露了一点具体细节。

GPT-4早在去年夏天就已经训练完成,后面一直在进行对齐工作,让它表现得更符合人类需求。

相比预训练数据集,RLHF所用的数据非常少,但效果是决定性的。

对此,奥特曼透露了一点数据来源,包含一些开源数据集、以及合作商提供的部分数据集。

当然,数据集中也有一点Reddit论坛上出现的迷因梗(meme),但不是很多。对此奥特曼遗憾表示:

如果再多点,它的回答可能会更有趣。

即便如此,团队甚至奥特曼自己依旧不能完全解读GPT-4。

目前对它的解读方式,依旧是通过不断问它问题,通过它的回答来判断它的“思路”。

而就在不断测试中,OpenAI发现从ChatGPT开始,GPT系列出现了推理能力。

虽然ChatGPT绝大部分时候都被当做数据库使用,但它确实也出现了一定的推理能力,至于这种能力具体如何出现的,目前却无人能回答。

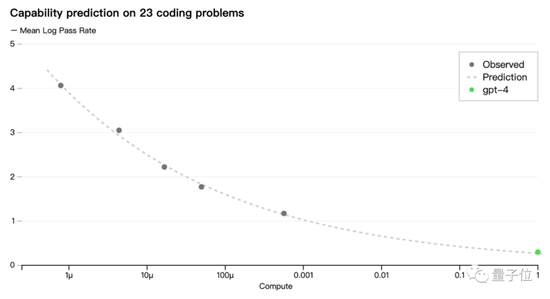

但大模型的训练往往意味着大量算力需求。对此奥特曼再次提到了OpenAI独特的训练预测方法:

即便模型很大,团队目前也有办法只通过部分训练,预测整个模型的性能,就像是预测一名1岁的婴儿能否通过SAT考试一样。

关于这一点,在GPT-4论文和官方博客中也有更详细介绍。

最后奥特曼承认,GPT-4确实存在应对不同价值观的人的问题。

临时解决办法就是把更改系统消息(system message)的权限开放给用户,也就是ChatGPT中经常见到的那段“我只是一个语言模型……”。

通过改变系统消息,GPT-4会更容易扮演其中规定的角色,比在对话中提出要求的重视程度更高,如规定GPT-4像苏格拉底一样说话,或者只用JSON格式回答问题。