昨天凌晨,在万众瞩目的苹果WWDC上,大家期盼了数年的苹果MR头显终于揭开了它的神秘面纱,瞬间引爆全球。用库克的话说,此次苹果Apple Vision Pro的革命性问世,标志着我们正式迈向空间计算时代,将开启个人化科技的全新征程。

Vision Pro非常酷,从铺天盖地的测评中,我们也看到了苹果在硬件、UI设计上的强大实力,瞄到了未来一代计算平台的可能,但激动之余,在这次整场发布会中,硅星人也在密切关注另一个重要议题——在当前滚滚的AI浪潮之下,苹果正在以及打算做什么?

而如果只是谈AI,这次的发布会可以说是一场大型失望中夹杂着一点希望的大会。有些期待的地方在于,虽然此次苹果只字未提AI这个词,但机器学习、Transformer模型等重要AI概念仍然不时出现,旗下的一众产品中也都更新了一些AI功能,除此之外,MR头显的推出或许还将打开苹果AI应用的全新想象空间。

不过,整场发布会没有推出一款基于生成式AI的自研产品,甚至隔壁微软都已经开始全系统层面启用AI助手了,苹果这次还在玩语音转文字、键盘自动纠错填充这些老游戏——这难免让人有些失望。别忘了,当初可是苹果的Siri开启了语音助手的时代。但在如今ChatGPT席卷全球的情况下,苹果的Siri只是少了个”Hey“?

至少从今年的WWDC来看,苹果在AI上努力了一下,但不多。

WWDC上,这次苹果揭晓了哪些AI更新?

跟5月刚刚落幕的谷歌IO和微软的Build几乎都围绕着AI展开不同,此次苹果的开发者大会的AI更像是彩蛋般的存在,埋在硬件和软件的更新里。虽然带来一些产品上的优化,却没有让人眼前一亮的存在。

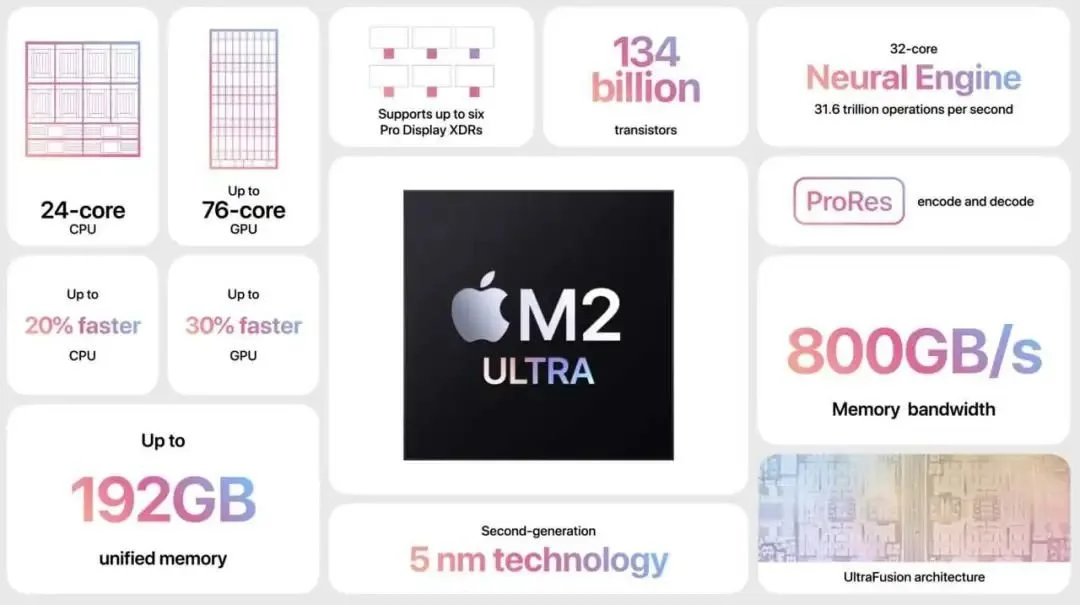

首先在硬件层面,全新发布的M2 Ultra 芯片通过将两块 M2 Max 芯片结合在一起,最高可实现 192GB 的统一内存,比 M1 Ultra 多 50%,从而能够流畅支持大模型的运算,完成其他芯片无法完成的任务。比如,苹果表示M2 Ultra相比其他PC设备可以在支持 Transformer 大模型运行上优势明显。

除了芯片,AirPods也悄悄引入了一些AI支撑下的新功能。比如,现在AirPods已经具备了“自适应音频”的能力,能够根据你所处的环境或记住你不同时段的偏好来自动调节媒体播放音量,让你能够专注于内容或与人交流,这背后则是来自于机器学习技术的支持。

此外,伴随着操作系统的升级,一些实用的AI小功能也开始提供给苹果用户。但老实说,并没有什么亮点,都给人一种似曾相识的感觉。

首先iOS 17此次新增了一个名为Journal的新原生应用程序,类似于此前Memory的升级版。基于机器学习技术,iPhone现在能够智能化地标记和记录用户生活中的重大事件或有趣瞬间,并自动为照片、音乐、录音等的任何条目添加详细信息来方便用户回溯